Die Nachfrage nach Künstlicher Intelligenz (KI) steigt kontinuierlich und damit auch der Bedarf an Rechen-Kapazitäten. KI-Anwendungen wie Deep Learning, Simulationen oder Prognosen benötigen enorm leistungsfähige Hardware, um aus komplexen Datensätzen valide Ergebnisse zu generieren. Server-Systeme mit NVIDIAs Grace Hopper TM Chip erfüllt diese Anforderungen heute und zukünftig perfekt: Der Superchip wurde speziell für das Training großer KI-Modelle, für generative KI, Recommender Systeme und Datenanalyse entwickelt.

Hier geht's zum Superchip-Wissen aus 1. Hand

AI Today - Ready for Take-off

Der Fortschritt der smarten KI-Technologien stieg in den vergangenen Jahren rasant: KI-Anwendungen wie Chat GPT, Simulationen in Bereichen wie der Medizin oder Recommender Systeme in Online-Shops lösen anspruchsvolle Aufgaben und erleichtern uns das tägliche Leben. Immer intelligentere Algorithmen und komplexere Datenanalysen vervielfältigen die Anwendungsmöglichkeiten. Der KI-getriebene Fortschritt benötigt aber Rechenleistung - und davon immer mehr. Systemarchitekturen wie NVIDIAs Grace Hopper TM liefern die nötige Power.

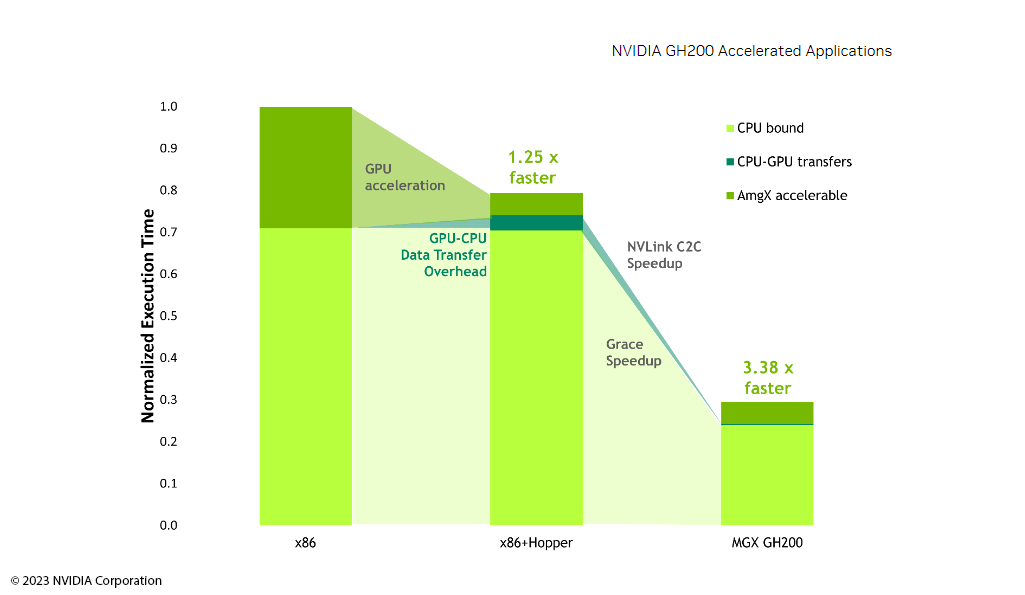

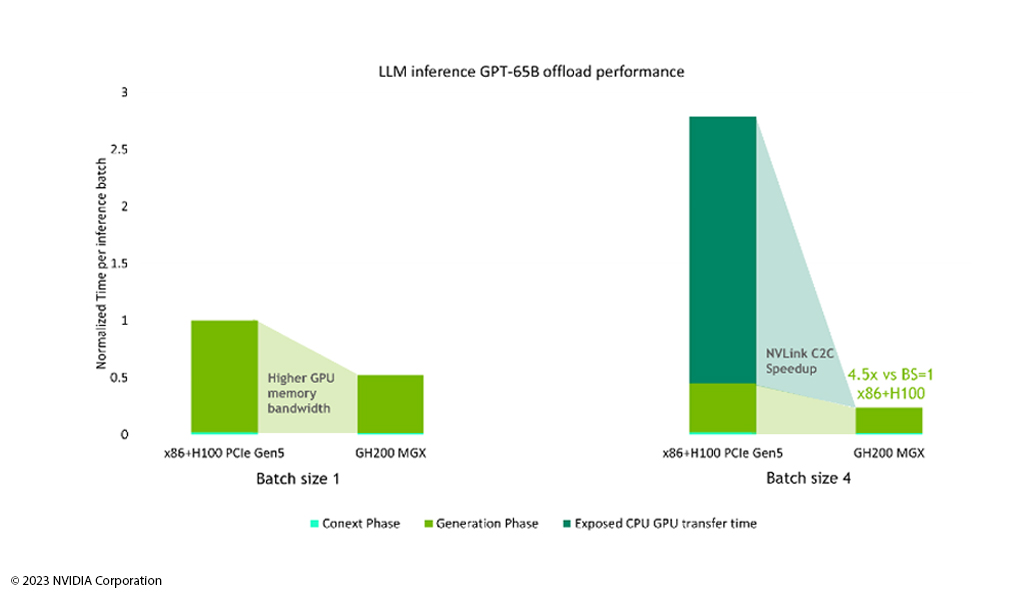

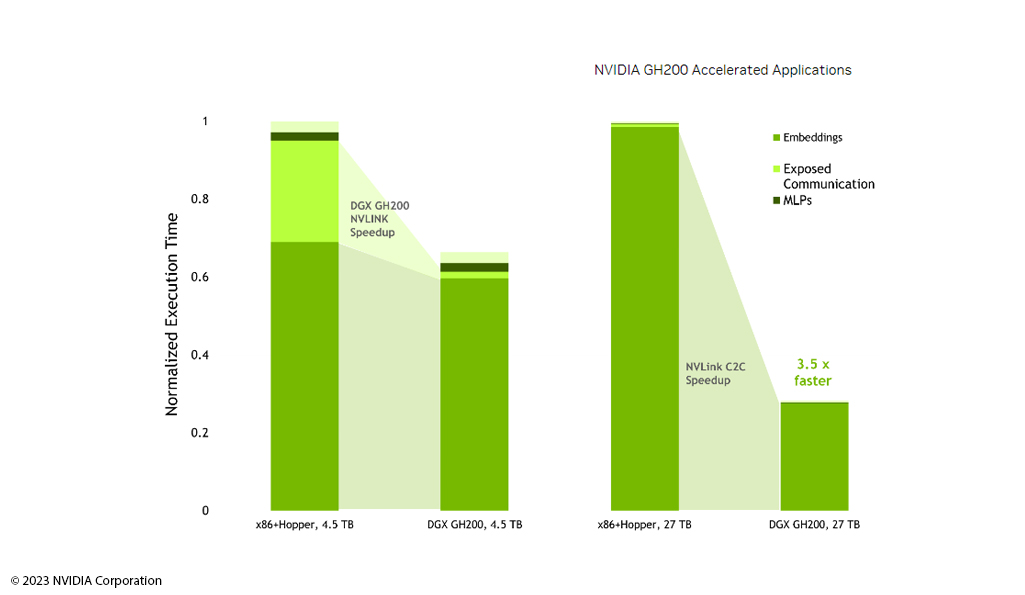

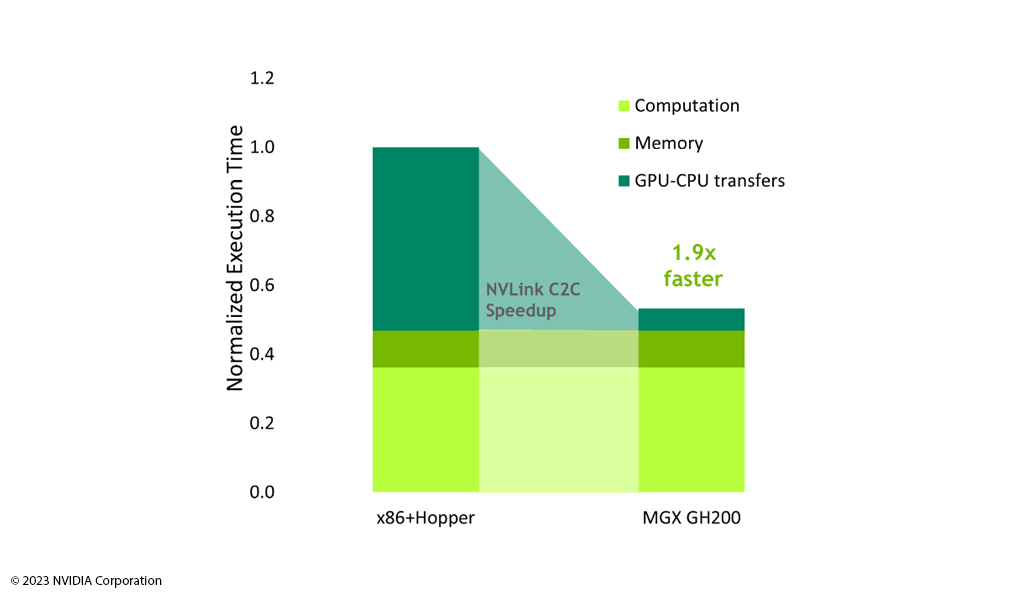

- Leistungsfähig: Grace Hoppers TM Kombination aus GPU, CPU und NVLink Interconnect bietet maximale Performance über viele Benchmarks.

- Vielseitig: Es gibt bereits viele Anwendungen, die auf Grace Hopper TM laufen, und es werden immer mehr.

- Energiesparend: NVIDIA Grace Hopper TM benötigt im Vergleich mit x86 Systemen weniger Energie.

Mit Best Practices zum Erfolg

Server-Systeme mit NVIDIA Grace Hopper

TM

Superchip:

Die erste Wahl für Ihre CEA-Workloads

-

Erfahren Sie mehr über die derzeit leistungsstärkste Architektur auf dem Markt, mit der Sie umfangreiche KI-Berechnungen und komplexe CAE-Simulationen in kürzester Zeit meistern.

- Introducing Grace Hopper:

Lernen Sie die leistungsstarke Architektur aus der NVIDIA Hopper GPU mit dem

Grace CPU (ARM Architecture) und dem schnellen NVLink Chip-2-Chip (C2C) kennen. - Optimized Performance:

NVIDIAs Grace Hopper TM liefert enorme Leistung, um umfangreiche CAE/CFD-Workloads

in kürzester Zeit zu bearbeiten. - Benchmark Insights:

Grace Hopper TM ist bei der CFD Software OpenFOAM besonders performant.

Erfahren Sie mehr Details anhand von ausgewählten Benchmarks. - Order Now and Starting with Computing Power for AI:

NVIDIA Grace Hopper TM Superchip ist ab sofort über GNS Systems erhältlich.

Ihre individuelle Beratung für

5 x höhere Leistung

Sie haben Fragen? Dann nehmen Sie Kontakt zu uns auf. Unsere Experten beraten Sie gerne rund um Grace Hopper TM und leistungsfähige Serversysteme zur effizienten KI-Nutzung.

Beste Performance für KI

Architecture Features

NVIDIAs Grace Hopper

TM

kombiniert die leistungsstarke Hopper GPU mit dem Grace CPU (ARM Architecture) und verbindet sie mit dem schnellen NVLink Chip-2-Chip (C2C).

Als erste NVIDIA-Datacenter-CPU für HPC und AI Workloads verwendet die

NVIDIA Grace CPU

72 Arm Neoverse V2 CPU-Kerne, um die maximale pro-Thread-Leistung aus dem System herauszuholen. Bis zu 480 GB LPDDR5X-Speicher bieten die optimale Balance zwischen Speicherkapazität, Energieeffizienz und Leistung.

NVIDIA Hopper

ist die neunte Generation der NVIDIA-Datacenter-GPU und ist speziell auf groß angelegte KI- und HPC-Anwendungen ausgelegt. Die verwendeten Thread Block Clusters und Thread Block Reconfiguration verbessern die räumliche und zeitliche Datenlokalität und halten die verwendeten Einheiten ausgelastet.

NVIDIA NVLink-C2C

ist NVIDIAs speicherkohärenter und latenzarmer Verbindungsstandard für Superchips. Es bildet das Herzstück des Grace Hopper

TM

Superchips und liefert eine Gesamtbandbreite von bis zu 900 GB/s.

|

Processor

|

Processor Family: NVIDIA Grace Hopper TM Superchip Processor Type: NVIDIA Grace TM 72 Arm® Neoverse V2 cores Max. TDP Support: 1000W Number of Processors: (1) Processors Internal Interconnect: NVIDIA® NV-Link®-C2C 900GB/s |

|

Form Factor

|

2U Rackmount |

| Dimensions | W x H x D (inch): 17.24" x 3.44" x 35.43" W x H x D (inch): 438 x 87.5 x 900mm |

|

Storage

|

Default Configuration: (4) E1.S NVMe SSD

|

|

Memory

|

Capacity: Up to 480GB LPDDRX embedded 96GB HBM3 GPU memory

|

|

Expansion Slot

|

Default Configuration: (3) PCle 5.0 x16 FHFL Dual Width slots

|

|

Front I/O

|

Power / ID / Reset Button Power / ID / Status LEDs (2) USB 3.0 ports (1) VGA port |

|

Storage Controller

|

Broadcom HBA 9500 Series Storage Adaptor Broadcom MegaRAID 9560 Series |

| Power Supply |

1+1 High efficiency hot-plug 2000W PSU, 80 Plus Titanium |

Ob Deep Learning, NLP (Natural Language Processing) oder Datenanalyse –

NVIDIAs Grace Hopper

TM

liefert enorme Leistung, um umfangreiche KI-Berechnungen und Simulationen

komplexer Zusammenhänge in kürzester Zeit zu ermöglichen.

Unsere Partner für Ihren Erfolg

Gemeinsam mit unseren langjährigen Partnern beraten wir Sie ganzheitlich sowie detailtief und sorgen für eine praxisbewährte Umsetzung ihrer KI-Infrastrukturen.